* 自動翻訳した記事に、編集を加えています。

生成AI革命が到来し、私たちの仕事や私生活に変化をもたらすことは疑いようがない。

しかし、この変革は全てがポジティブなものではなく、生成AI搭載型の新しい世界において倫理的な配慮をすべきであるという報告が数多くなされている。まず、AIに電力を供給するだけでも環境に深刻な影響を及ぼす可能性がある。2027年までにAIの電力消費量は世界の電力消費量の0.5%以上を占めると推定され、これはアルゼンチンの年間電力消費量に相当する。そしてここにも、重要な倫理的ジレンマがある。

メディア業界は、生成AIが台頭する中で倫理的な業界基準をどのように維持するか、今すぐに検討しなくてはならない。率直に言って、私たちは既にその渦中にいるからだ。IPG傘下のマグナ(Magna)によると、現在豪州ではデジタル広告費の85%をプログラマティック取引が占めており、わずか17%だった2015年から大幅に増加。アルゴリズムに基づいて、大量の広告が売買されている。

しかし、生成AIの輝きに惑わされてはならない。生成AIには以下のような落とし穴があるのだ。

1. 生成AIが、人間の直感を台無しにする可能性がある

メディア業界はここ数十年で、人間が抱きがちな偏見や、アルゴリズムが人々に不利益をもたらす可能性があることについて、認識を深めてきた。しかし生成AIが登場し、注意を怠るとこうした努力が台無しになる危険性がある。生成AIツールは非常に強力で効率的だが、まだかなり大雑把なためだ。例えば、白人男性が権力のある地位に就く可能性が高いことを示す大量のデータをAIに与えた場合、AIツールは疑うことなく上級リーダー=白人男性とみなす。その結果として、コンテンツや求人情報が他のどの属性よりも白人男性に偏り、労働力の公平性と多様性が妨げられる可能性があるのだ。

メディアバイイングの観点では、生成AIは人間のように推論することができないため、広告効果が制限される可能性がある。例えば、過去のエンゲージメントに基づいて特定の属性に過剰にターゲティングし、自己強化サイクルを生み出す可能性がある。これに対して、人間のメディアバイヤーは過去のデータだけに頼るのではなく、微妙な思考やエビデンスに基づくマーケティング原則を活用して、ブランドの成長に最適なオーディエンスを特定できる。生成AIの能力に加えて、人間をメンバーとして組み込んで現実世界の知識や洞察を活用することで、価値の高いオーディエンスにリーチする効果的なメディア戦略が可能になる。

2. パーソナライゼーションか、不気味さか? 生成AIのプライバシー管理

AIは飢えており、データを「食わせて」もらおうと、絶えず新しいデータを消費し続けている。 現在、豪州にはAIの使用を規制する一般法は無いが、2019年より自主的なAI倫理原則(AI Ethics Principles)がある。 今後、連邦プライバシー法に追加される可能性が高いが、現時点ではまだそこには至っていない。その間にも私たちの買い物や検索、リアルタイムの位置情報など、AIはあらゆる詳細に密接に関わっている。業界外の人々からすれば、「電話機が私の話を聞いているのか?」と疑問に思うのは当然のことだろう。確実にそうだとは言えないが、電話に向かって「オレオ(Oreo)」を数回言ってみて、次の広告でこの人気のクッキーが表示されるか試してみてはいかがだろうか。

メディアバイイングの担当者にとって、生成AIは消費者に気味悪がられることなくパーソナライゼーションをサポートしてくれる存在だろう。この領域は動きが速く、適切なペースで進めるには消費者やユーザーと徹底的に協力することが必須だ。つまり、多様な人々からなるフォーカスグループやコデザイン(参加型デザイン)を通じて広告の受け手に近付き、耳を傾けることで、マーケターとしてはインターネットの自由さと、本物かつ妥当に感じられる広告体験を絶妙なバランスで届けることができる。正確で、なおかつ監視されているような感覚を与えないことが目標だ。ストーカーに調べられているような気分になりたいなんていう人はいないのだから。

3. 正直さが最善策:生成AIの透明性向上に向けて

生成AIが、ツールの構築や研究に携わる人々から高い頻度で「ブラックボックス」と言及されることに驚くだろう。私たちは倫理的で賢明なメディアのプロフェッショナルとして、広告が特定の場所で特定のオーディエンスに対して表示された理由を、顧客やクライアントに説明できなければならない。そして説明できない場合には、正直であることが求められる。

実際に、透明性はAIのあらゆる用途において重要だ。メディアの専門家はAIを活用することで仕事を楽にこなすことができるし、そうすべきだろうが、AIの「力」を使うことについては正直であるべきだ。念のためにお伝えしておくと、私はこの記事のリサーチとアイデア出しにAIを活用したが、それによって、このコンテンツの価値や信憑性は低くなっただろうか?

マーケターとして、私たちはAIツールにさらなる透明性を求める必要がある。AIツールがどのように機能するかを理解し、社内外の全てのステークホルダーに説明できなければならない。クライアントに、なぜその広告が特定のオーディエンスに配信されたのか、あるいは、あるクリエイティブがなぜ別のものよりもパフォーマンスが優れていたのか説明する場面を想像してみよう。「AIがそうしたから」という単純な答えでは不十分だ。アルゴリズムの背後にあるロジックを理解して説明できるよう、その仕組みを調べられるようにしておく必要がある。

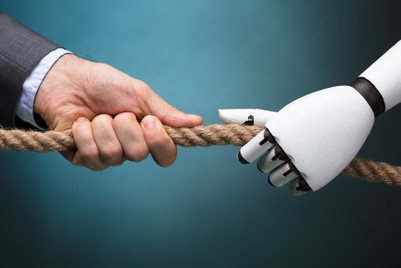

では、今後はどうすればよいのだろうか? 公平性、透明性、プライバシー、アカウンタビリティー(説明責任)、人間による監視という原則に基づく明確な倫理的フレームワークが、マーケティングにおけるAIには必要だと私は考えている。AIシステムに偏りがないか定期的に監査し、消費者のプライバシーを保護し、常に人間による制御を維持する必要がある。

業界として実行できる具体的な取り組みには、以下のようなものがある。

- 説明可能なAI:意思決定プロセスを明確に説明できるAIシステムを使用し、ソリューションの「ブラックボックス化」を回避するよう努める。

- 定期的な監査:AIツールの偏りや公平性、意図せぬ結果について、積極的にかつ定期的に評価し、問題が特定された場合には速やかに是正措置を講じる。

- プライバシーを配慮した設計:プライバシーへの配慮は後付けではなく、最初からAI戦略に組み込む必要がある。

- 人間の関与:AIは人間の意思決定を補ったり支援するためのものであり、完全に置き換えるものではない。人間による監視とアカウンタビリティーは極めて重要だ。

- 透明性と情報開示:AI がマーケティング活動に使用された場合は、その旨を明らかにする。透明性が信頼を生む。

生成AI の取り組みは、短距離走ではなくマラソンだ。切り抜けていくつもりのマーケターは、今から落とし穴を避けるのが最善策だろう。しかし、良い知らせもある。始めるにあたっては、ChatGPT に助けを求めることができるのだ。

チャールズ・ダンジボー氏は、イニシアティブ(Initiative)の戦略&西オーストラリア州政府担当責任者。